刚刚, 英伟达祭出下一代GPU! 狂飙百万token巨兽, 投1亿爆赚50亿

新智元报道

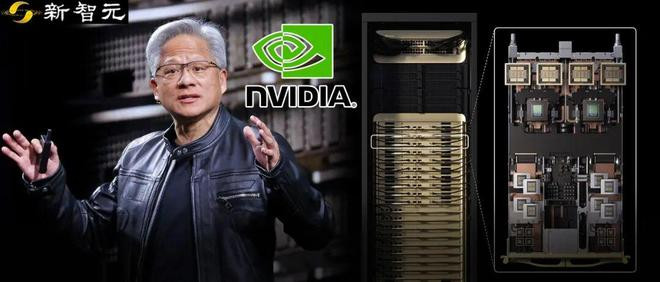

[新智元导读]昨天,英伟达重磅发布了专为海量上下文AI打造的CUDAGPU——RubinCPX,将大模型一次性推理带入「百万Token时代」。NVIDIA创始人兼CEO黄仁勋表示,VeraRubin平台将再次推动AI计算的前沿,不仅带来下一代RubinGPU,也将开创一个CPX的全新处理器类别。

「百万Token怪兽」出世!

昨天,NVIDIA突放大招,推出了RubinCPX,这是一款专为大规模上下文推理而设计的全新GPU。

它的性能,是VeraRubinNVL144平台的2倍多,是基于BlackwellUltra的GB300NVL72机架式系统的7.5倍!

它具有单机架8EFLOPS的NVFP4计算力、100TB高速内存与1.7PB/s的内存带宽、128GB的高性价比GDDR7显存。

相比较NVIDIAGB300NVL72系统,RubinCPX带来了3倍的注意力机制处理能力。

性能巨兽,在变现能力上更是不容小觑。

每投入1亿美元,最高可以带来50亿美元的Token收入!

RubinCPX

开创CPX全新处理器类别

RubinCPX基于Rubin架构构建,是首款专为海量上下文AI打造的CUDAGPU,能够在同一时间推理跨越数百万个知识标记的模型。

可以说,RubinCPX是专为破解AI「长上下文」瓶颈而生的「特种兵」。

它的出现,为AI带来了百万Token级推理场景下的性能和效率的新突破。

依托于全新的NVIDIAVeraRubinNVL144CPX平台,RubinCPX与NVIDIAVeraCPU和RubinGPU紧密协同,可以支持多步推理、持久化记忆与长时程上下文,这让它在面对软件开发、视频生成、深度研究等领域的复杂任务时,更加游刃有余。

这也意味着在RubinCPX的最新加持下,AI编码将从简单的代码生成工具,升级为能够理解并优化大规模软件项目的复杂系统。

同样,它还可以满足长视频与研究类应用领域,在数百万Token级别上保持持续一致性与记忆的需求。

这些需求,都在逼近当前基础设施的极限。

NVIDIA创始人兼CEO黄仁勋表示,VeraRubin平台将再次推动AI计算的前沿,也将开创一个CPX的全新处理器类别。

「正如RTX颠覆了图形与物理AI一样,RubinCPX是首个专为海量上下文AI打造的CUDAGPU,模型能够一次性跨越数百万个Token的知识进行推理。」

目前,Cursor、Runway和Magic等AI先锋企业,正在积极探索RubinCPX在应用加速上的新可能。

30-50倍ROI

重写推理经济

RubinCPX通过解耦式推理创新,可以企业带来30-50倍ROI,重写推理经济。

大模型的推理,主要分为上下文和生成两个阶段。

它们对于基础设施的要求,也存在着本质性的差异。

上下文阶段,以计算受限为主,需要高吞吐处理来摄取并分析海量输入数据,以产出第一个Token的输出结果。

而生成阶段,则以内存带宽受限为主,依赖快速的内存传输与高速互联(如NVLink)来维持逐Token的输出性能。

解耦式推理,可以让这两个阶段独立处理,从而更加针对性地优化算力与内存资源,提升吞吐,降低时延,增强整体资源的利用率。

但解耦式推理,也带来了新的复杂性层次,需要在低时延KV缓存传输、面向大模型感知的路由,以及高效内存管理之间进行精确协调。

这离不开NVIDIADynamo,它作为以上组件的编排层,发挥着关键作用。

RubinCPX是专为大语言模型(尤其是百万Token上下文)推理设计的「专用加速器」。

RubinCPX与NVIDIAVeraCPU,以及用于生成阶段处理的RubinGPU协同工作,共同形成了面对长上下文场景的完整的高性能解耦式服务方案。

CPX的推出,标志着解耦式推理基础设施的最新进化,也树立了推理经济的新标杆。

在规模化场景下,NVIDIAVeraRubinNVL144CPX平台,可带来30–50x的投资回报(ROI)。

这意味着1亿美元的资本性支出(CAPEX),最高可转化为50亿美元的收入。

百万Token怪兽

重新定义下一代AI应用

VeraRubinNVL144CPX平台,重新定义了企业构建下一代生成式AI应用的可能性。

NVIDIAVeraRubinNVL144CPX机架与托盘,配备Rubin上下文GPU(RubinCPX)、RubinGPU与VeraCPU

RubinCPX与NVIDIAVeraCPU、RubinGPU,共同集成在全新的NVIDIAVeraRubinNVL144CPX平台内。

NVIDIAVeraRubinNVL144CPX平台,采用最新GPU架构,具备极高算力与能效比,可以基于MGX架构实现机架级部署。

1.算力跃升

NVIDIAMGX机架式系统,单机架集成了144块RubinCPXGPU、144块RubinGPU与36颗VeraCPU,可以提供8EFLOPS的NVFP4计算力,并在单机架内配备100TB高速内存与1.7PB/s的内存带宽。

2.长序列的高效处理优化

RubinCPX针对长序列的高效处理进行了优化,是软件应用开发与高清(HD)视频生成等高价值推理用例的关键。

3.显存升级

单个RubinCPXGPU可以提供高达30petaflops的NVFP4计算能力,它配备128GB的高性价比GDDR7显存,以加速最苛刻的上下文类工作负载。

4.注意力机制加速

相比NVIDIAGB300NVL72系统,RubinCPX带来了3倍的注意力机制处理能力,显著提高模型处理更长上下文序列的能力且不降速。

5.多种形态配置

RubinCPX提供多种形态配置,包括VeraRubinNVL144CPX,并可与NVIDIAQuantum-X800InfiniBand横向扩展计算网络。

也可以搭配采用NVIDIASpectrum-XGS以太网技术与NVIDIAConnectX®-9SuperNICs™的NVIDIASpectrum-X™以太网网络平台结合使用,以实现大规模部署。

RubinCPX

拥抱NVIDIA全栈AI生态

在生态上,RubinCPX将得到完整的NVIDIAAI堆栈支持,包括:

NVIDIARubinCPX预计将于2026年底可用。

它的推出将为全球开发者与创作者解锁更强大的能力,重新定义企业构建下一代生成式AI应用的可能性。